TechHype

Что такое Градиентный спуск

Градиентный спуск — это оптимизационный алгоритм, который используется для нахождения минимального или максимального значения функции.

Градиентный спуск — это оптимизационный алгоритм, который используется для нахождения минимального или максимального значения функции. Этот алгоритм часто применяется в машинном обучении и искусственном интеллекте для минимизации функции потерь, которая измеряет, насколько далеко предсказания модели от фактических результатов.

Принцип работы градиентного спуска заключается в следующем:

- Выбирается начальная точка (начальные значения параметров модели).

- Вычисляется градиент функции потерь в этой точке, то есть вектор частных производных, который показывает направление наискорейшего роста функции.

- Делается шаг в направлении, противоположном градиенту (в сторону наискорейшего убывания функции), что приводит к уменьшению значения функции.

- Размер шага определяется параметром, называемым скоростью обучения (learning rate).

- Процесс повторяется итеративно до тех пор, пока не будет достигнут критерий остановки, например, до достижения заданного числа итераций, до того, как изменение функции потерь станет незначительным или до того, как градиент приблизится к нулю.

Существуют различные варианты градиентного спуска:

- Стандартный градиентный спуск (Batch Gradient Descent): Вычисляет градиент, используя все обучающие данные на каждом шаге, что может быть неэффективно для больших наборов данных.

- Стохастический градиентный спуск (Stochastic Gradient Descent, SGD): Вычисляет градиент на основе одного обучающего примера, выбранного случайным образом, на каждом шаге, что делает алгоритм более быстрым и способным к обновлению модели онлайн.

- Мини-пакетный градиентный спуск (Mini-batch Gradient Descent): Компромисс между двумя предыдущими методами, вычисляет градиент на основе небольшой выборки данных (мини-пакета), что позволяет более эффективно использовать ресурсы и обеспечивает более стабильное схождение.

Этот алгоритм является мощным инструментом в оптимизации, но также имеет свои сложности, такие как выбор подходящей скорости обучения и риск застревания в локальных минимумах функции потерь.

Где используется градиентный спуск

Алгоритм используется во многих областях, где требуется оптимизация и нахождение минимальных значений функций. Основные применения градиентного спуска включают:

- Машинное обучение и искусственный интеллект: Градиентный спуск является ключевым алгоритмом для тренировки и оптимизации моделей машинного обучения, включая нейронные сети, регрессионные модели и алгоритмы классификации.

- Глубокое обучение: В нейронных сетях алгоритм используется для минимизации функции потерь путем корректировки весов и смещений в слоях сети.

- Оптимизация: Градиентный спуск применяется в задачах оптимизации для нахождения минимальных значений сложных функций в инженерии, экономике и научных исследованиях.

- Компьютерное зрение: В области компьютерного зрения алгоритм используется для решения задач, таких как распознавание образов и машинное зрение.

- Обработка естественного языка (NLP): Алгоритмы для анализа и генерации естественного языка алгоритм используют для оптимизации моделей, которые работают с текстовыми данными.

- Рекомендательные системы: Для предсказания предпочтений пользователей и рекомендации продуктов используются алгоритмы, оптимизированные с помощью градиентного спуска.

- Финансы: В финансовом моделировании градиентный спуск может использоваться для оптимизации портфелей и нахождения стратегий управления рисками.

- Энергетика: В области оптимизации энергетических систем градиентный спуск помогает минимизировать затраты и оптимизировать распределение ресурсов.

- Управление роботами: Градиентный спуск используется для планирования траекторий и оптимизации движений роботов.

- Медицина: В биоинформатике и медицинской визуализации метод помогает в анализе медицинских изображений и в моделировании биологических процессов.

Метод особенно полезен в задачах, где аналитическое решение трудно найти или не существует, и где можно применить численные методы для итеративного приближения к оптимальному решению.

Применение градиентного спуска в машинном обучении

Градиентный спуск является основой для многих алгоритмов машинного обучения и их практического применения. Вот несколько примеров, где он используется.

Линейная регрессия: Градиентный спуск используется для минимизации функции стоимости (обычно среднеквадратичной ошибки) при подборе параметров линейной модели, чтобы наилучшим образом аппроксимировать зависимость между независимыми и зависимыми переменными.

Логистическая регрессия: В задачах классификации логистическая регрессия использует спуск для оптимизации параметров модели таким образом, чтобы вероятность принадлежности примеров к определенному классу была максимально точной.

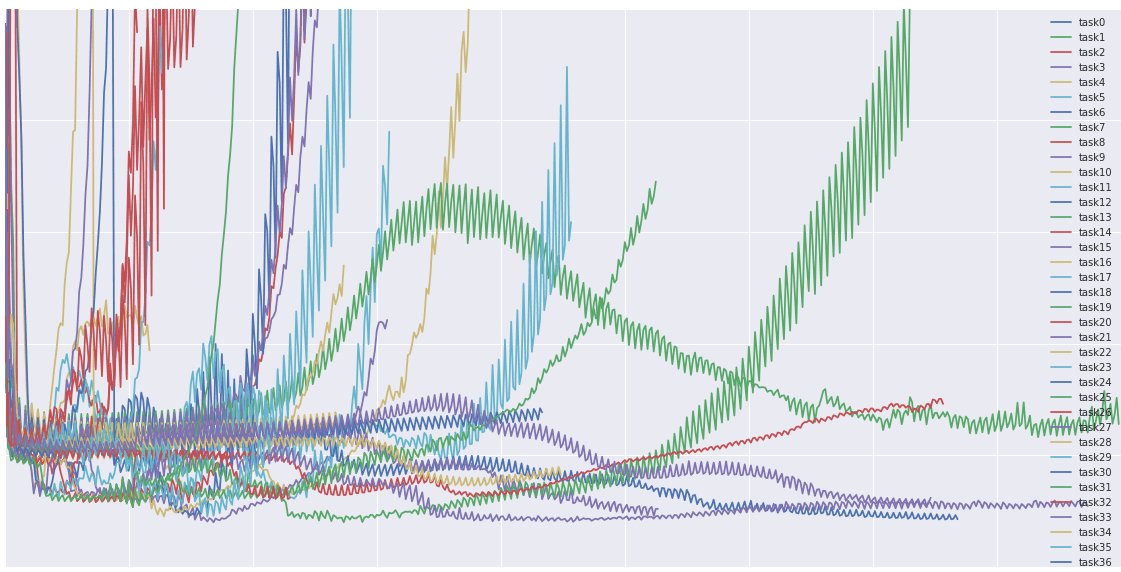

Нейронные сети и глубокое обучение: Метод, особенно его варианты, такие как стохастический градиентный спуск (SGD) и его оптимизированные версии (например, Adam, RMSprop), используются для обновления весов в нейронных сетях в процессе обратного распространения ошибки.

Метод опорных векторов (SVM): Для нахождения оптимальной разделяющей гиперплоскости в задачах классификации и регрессии градиентный спуск может использоваться для минимизации функции потерь, включающей регуляризационный термин.

Кластеризация: Алгоритмы кластеризации, такие как K-средних, могут использовать градиентный спуск для минимизации суммы квадратов расстояний от точек до центров их кластеров.

Рекомендательные системы: Алгоритм используется для оптимизации матриц в моделях коллаборативной фильтрации, чтобы минимизировать разницу между известными рейтингами и предсказаниями модели.

Уменьшение размерности: Алгоритмы, такие как t-SNE, используют градиентный спуск для уменьшения размерности данных, сохраняя при этом структуру и важные отношения между точками в многомерном пространстве.

Настройка гиперпараметров: Некоторые методы автоматической настройки гиперпараметров, например, градиентный спуск по гиперпараметрам, используют градиентный спуск для оптимизации гиперпараметров модели.

Эти примеры демонстрируют универсальность и важность градиентного спуска в машинном обучении. Он лежит в основе многих алгоритмов, которые решают разнообразные задачи, от прогнозирования и классификации до автоматического распознавания образов и многого другого.

Простой пример градиентного спуска

Вот простая реализация градиентного спуска на Swift, которая минимизирует квадратичную функцию потерь (например, функцию f(x) = (x — 5)², минимум которой находится в точке x = 5:

func gradientDescent(startingPoint x: Double, learningRate alpha: Double, numberOfSteps: Int) -> Double {

var x = x // Текущее значение x

for _ in 0..<numberOfSteps {

let gradient = 2 * (x - 5) // Производная функции (x - 5)^2

x -= alpha * gradient // Обновляем x, двигаясь в направлении, противоположном градиенту

}

return x

}

// Использование функции градиентного спуска

let startingPoint: Double = 0 // Начальная точка

let learningRate: Double = 0.1 // Скорость обучения

let numberOfSteps: Int = 100 // Количество шагов

let minimum = gradientDescent(startingPoint: startingPoint, learningRate: learningRate, numberOfSteps: numberOfSteps)

print("Минимум функции находится в точке: \(minimum)")

Этот код определяет функцию gradientDescent, которая принимает начальную точку x, скорость обучения alpha и количество шагов numberOfSteps. Функция выполняет итеративное обновление значения x, вычитая произведение скорости обучения на градиент функции в текущей точке. В результате после заданного числа шагов функция возвращает значение x, которое является приближением к минимуму исходной функции.

-

Вовлечение пользователей4 недели назад

Большинство приложений терпят неудачу не из-за плохой «идеи»

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2026.4

-

Видео и подкасты для разработчиков4 недели назад

Изоляционно-плагинная архитектура в Dart-приложениях, переносимость на Flutter

-

Видео и подкасты для разработчиков2 недели назад

Видео droidcon London 2025