Новости

Исследователи Apple разработали LLM, которая понимает интерфейс приложений

Хотя мы не знаем, будет ли новая модель включена в такие системы, как Siri, Ferret-UI предлагает возможность расширенного контроля над таким устройством, как iPhone.

Работа, опубликованная в понедельник Корнельским университетом, называется «Ferret-UI: Глубинное понимание мобильного пользовательского интерфейса с помощью мультимодальных LLM». По сути, в ней рассказывается о новой мультимодальной большой языковой модели (MLLM), которая способна понять пользовательские интерфейсы мобильных приложений.

Название Ferret первоначально появилось благодаря мультимодальной LLM с открытым исходным кодом, выпущенной в октябре исследователями из Корнельского университета совместно с коллегами из Apple. В то время Ferret мог обнаруживать и понимать различные области изображения для выполнения сложных запросов, таких как определение вида животного на выбранной части фотографии.

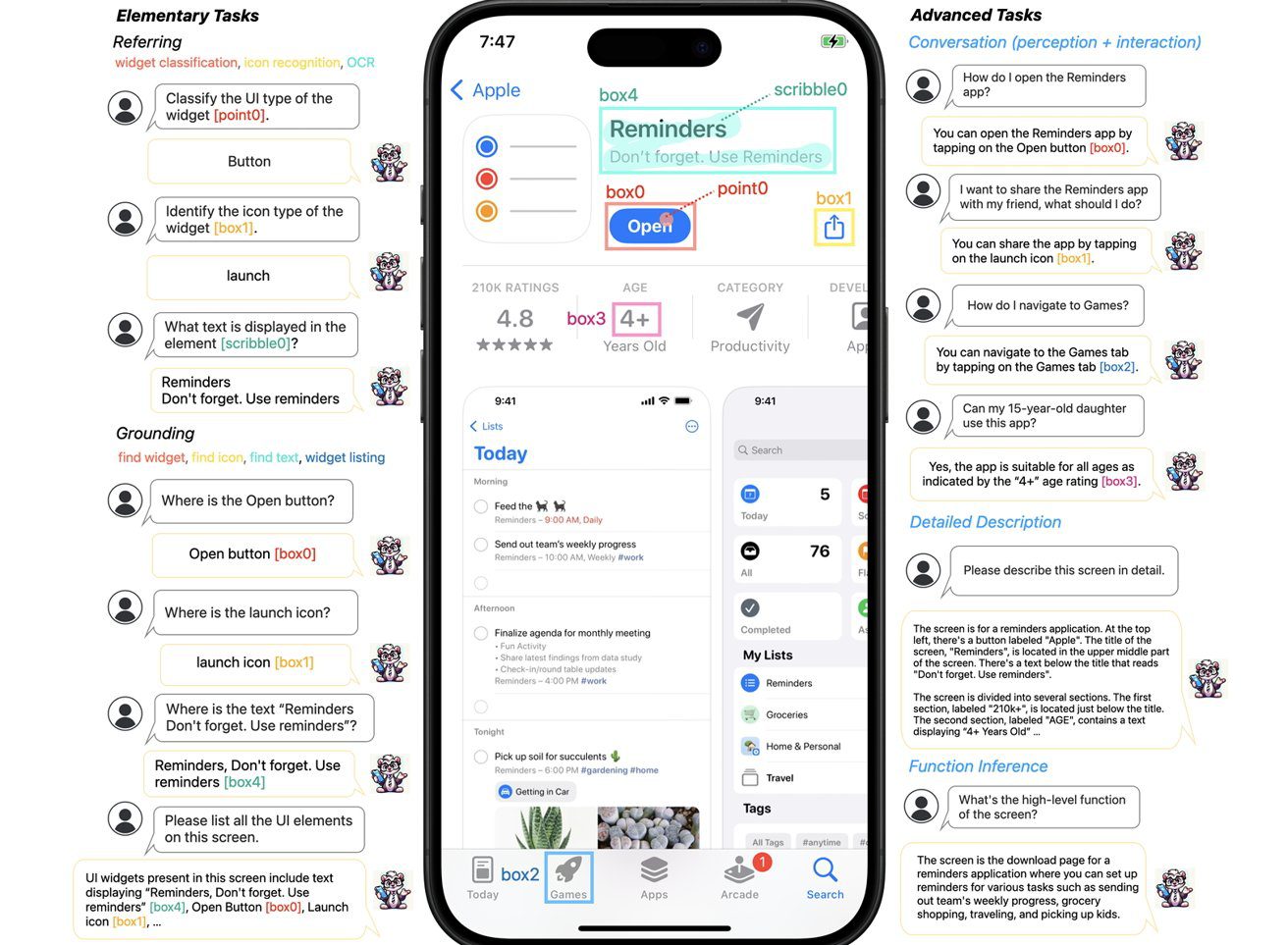

В новой работе Ferret-UI объясняется, что, несмотря на значительные успехи в использовании MLLM, они все еще «не способны эффективно понимать и взаимодействовать с экранами пользовательского интерфейса (UI)». Ferret-UI описывается как новая MLLM, предназначенная для понимания мобильных пользовательских интерфейсов, с «возможностями отсылки, обоснования и рассуждения».

Часть проблемы, с которой сталкиваются модели при понимании интерфейса, заключается в том, как он вообще используется. Часто в портретной ориентации иконки и другие детали могут занимать очень компактную часть дисплея, что затрудняет понимание машинами.

Чтобы помочь в этом, в Ferret есть система увеличения изображений до «любого разрешения», чтобы сделать иконки и текст более читаемыми.

Для обработки и обучения Ferret также делит экран на две части, разрезая его пополам. В статье говорится, что другие LLM, как правило, сканируют большое изображение с меньшим разрешением, что снижает возможность адекватно определить, как выглядят иконки.

Если добавить к этому значительную обработку данных для обучения, то получится модель, способная достаточно хорошо понимать запросы пользователей, понимать природу различных экранных элементов и предлагать контекстные ответы.

Например, пользователь может спросить, как открыть приложение «Напоминания», и ему ответят, что нужно нажать на экранную кнопку «Открыть». Другой запрос, спрашивающий, может ли 15-летний подросток использовать приложение, может проверить возрастные рекомендации, если они видны на экране.

Хотя мы не знаем, будет ли новая модель включена в такие системы, как Siri, Ferret-UI предлагает возможность расширенного контроля над таким устройством, как iPhone. Понимая элементы пользовательского интерфейса, он дает возможность Siri выполнять действия за пользователя в приложениях, самостоятельно выбирая элементы в приложении.

Существуют также полезные приложения для людей с ослабленным зрением. Такой LLM сможет более подробно объяснять, что происходит на экране, и, возможно, выполнять действия за пользователя, не требуя от него ничего другого, кроме как попросить об этом.

-

Маркетинг и монетизация2 недели назад

Как ML-подход удвоил первые покупки при снижении CPI, CAC, ДРР: «Яндекс Маркет» и Bidease

-

Видео и подкасты для разработчиков3 недели назад

Видео droidcon London 2025

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2026.5

-

Новости3 недели назад

Видео и подкасты о мобильной разработке 2026.6