Исследования

Иллюзия мышления — исследование Apple «рассуждающих» языковых моделей

Другими словами, мы не учим машины думать — мы просто делаем их более точными в своих предположениях. И, как напоминает нам исследование Apple, больше предположений не всегда означает больше интеллекта.

Apple недавно охладила энтузиазм по поводу одного из самых обсуждаемых достижений в области искусственного интеллекта — моделей рассуждения. В новой исследовательской работе под названием «Иллюзия мышления: понимание сильных сторон и ограничений моделей рассуждения через призму сложности проблемы» команда Apple по машинному обучению утверждает, что модели, разработанные для имитации человеческого рассуждения, не представляют собой значительного прогресса по сравнению с традиционными большими языковыми моделями (LLM).

Основные выводы: когда модели рассуждений дают сбой

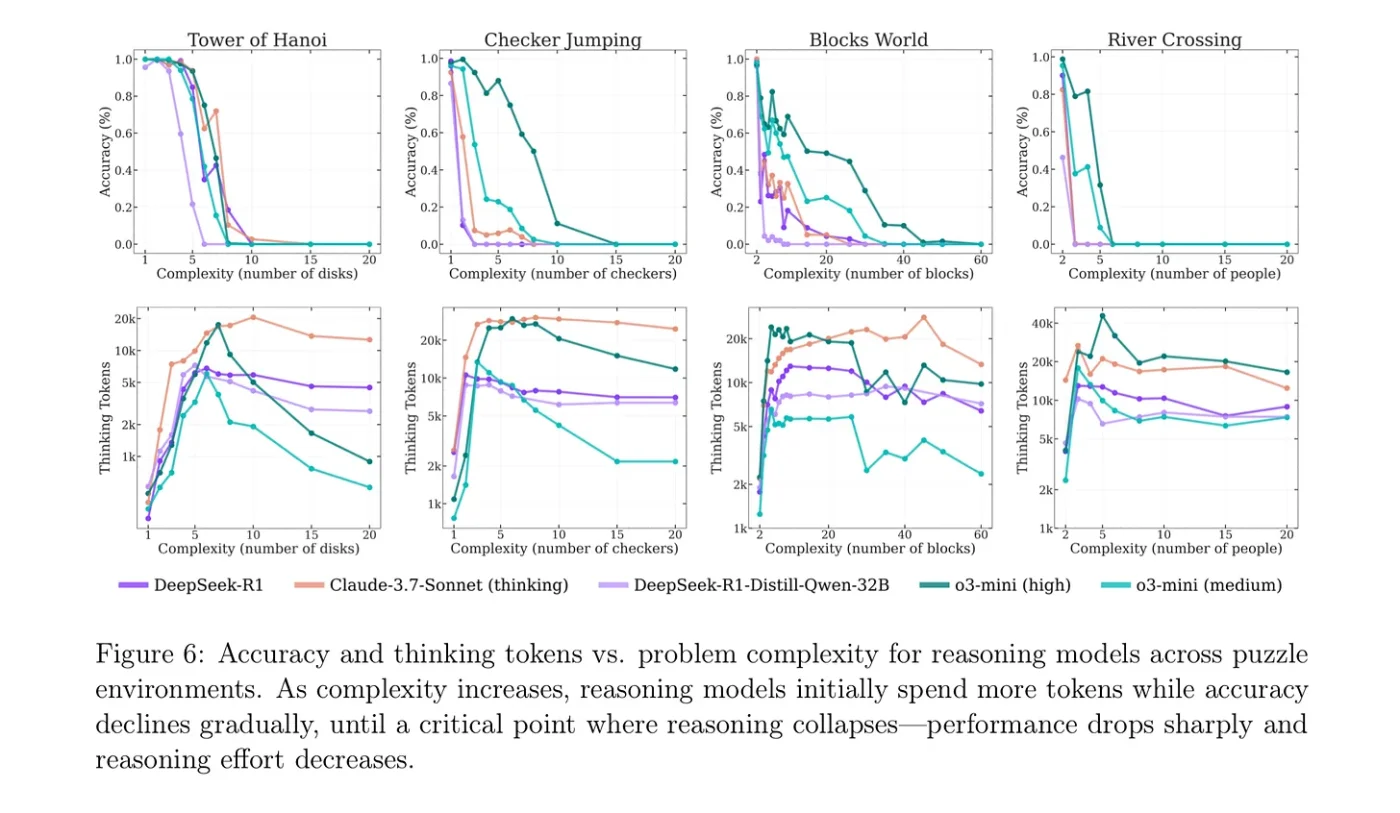

В исследовании Apple представлена трехуровневая структура для оценки производительности моделей в зависимости от сложности задачи:

- Задачи низкой сложности: удивительно, но в этом случае стандартные LLM превосходят модели рассуждений. Они более эффективны и результативны, решая простые проблемы без лишних затрат на цепочки рассуждений.

- Задачи средней сложности: здесь модели рассуждений показывают себя с лучшей стороны. Они, как правило, превосходят базовые LLM, что свидетельствует о некоторой ценности использования структурированных цепочек рассуждений, но только в узком диапазоне задач.

- Задачи высокой сложности: оба типа моделей терпят крах. Когда задачи требуют нескольких уровней логики, как модели рассуждений, так и стандартные LLM дают сбой. Даже при наличии достаточного количества токенов и времени модели рассуждений начинают регрессировать, давая худшие результаты при решении более сложных задач.

Один из самых поразительных выводов? По мере увеличения сложности модели рассуждений часто рассуждают меньше, а не больше. Их производительность резко падает, демонстрируя неспособность масштабировать глубину логики или поддерживать связные цепочки рассуждений при решении сложных задач.

Небольшие сбои, большие неудачи

Еще одно открытие заключается в том, насколько хрупкими являются эти модели. Компания Apple обнаружила, что внесение небольших, несущественных изменений в подсказку, например добавление лишнего предложения, может снизить производительность на 65%. Это говорит о том, что модели рассуждения в меньшей степени полагаются на фактическую логику, а в большей степени на распознавание паттернов, которые легко сбиваются шумом.

Это открытие усиливает опасения, которые разделяют многие в сообществе исследователей искусственного интеллекта: современные LLM на самом деле не «думают» так, как люди — они имитируют мышление с помощью статистических догадок.

Отсутствие доказательств истинной логики

В статье Apple были рассмотрены тесты структурированного мышления и задачи, похожие на головоломки, предназначенные для проверки формальной логики. Результат? Не было найдено никаких значимых доказательств того, что эти модели используют фактическое дедуктивное или символическое мышление. Вместо этого они действуют скорее как вероятностные магнитофоны, предсказывая следующий символ на основе шаблонов, которые они видели во время обучения, а не выводя ответы на основе первоначальных принципов.

Это доказательство несостоятельности нынешнего ажиотажа вокруг «цепочки мыслей». Эти результаты могут казаться продуманными, но на самом деле модели не занимаются ничем похожим на логическое решение проблем.

Реакция сообщества

На Reddit’s r/singularity один пользователь подытожил это так:

Модели без рассуждений более эффективны… модели с рассуждениями лучше подходят для задач средней сложности… все не очень хороши для очень сложных задач.

Другой комментатор возразил:

«Они говорят, что улучшения в моделях с рассуждениями не так уж и значительны… но я думаю, что это просто неправда».

Это разделение отражает более широкое противоречие в области ИИ. Некоторые считают, что мы находимся на пороге появления AGI, способного к рассуждению; другие утверждают, что мы все еще оттачиваем те же старые статистические приемы.

Почему позиция Apple имеет смысл

Неубедительная позиция Apple в отношении моделей рассуждения не является чисто академической — она вписывается в их более широкую философию ИИ. В отличие от Google или OpenAI, которые вкладывают значительные средства в мультиагентные системы рассуждения и массивные контекстные окна, Apple уделяет приоритетное внимание устройствам, сохраняющим конфиденциальность, и эффективному ИИ. В этом контексте модели рассуждения — часто более крупные, более медленные и более уязвимые — не имеют большого смысла.

Исследование Apple — это не отказ от будущего ИИ с рассуждениями. Скорее, это проверка реальности. Эти модели не бесполезны, но и не являются волшебными. Их преимущества ограничены узким кругом задач, а их надежность вызывает сомнения.

Реальный вывод

Это исследование появилось в очень важный момент. Компании, занимающиеся искусственным интеллектом, стремятся создать «мыслящие» модели, но работа Apple показывает, что многие из этих усилий по-прежнему являются скорее иллюзией, чем интеллектом. В настоящее время рассуждения являются неустойчивыми, неэффективными и не являются панацеей.

Другими словами, мы не учим машины думать — мы просто делаем их более точными в своих предположениях. И, как напоминает нам исследование Apple, больше предположений не всегда означает больше интеллекта.

Эти выводы ставят под сомнение растущее убеждение, что способности к рассуждению необходимы для создания более «интеллектуальных» моделей. Вместо этого Apple утверждает, что эти так называемые «рассуждающие» LLM могут давать лишь ограниченные преимущества, а в некоторых случаях могут работать хуже, чем более простые модели.

Однако многие критики выражают скептицизм по поводу выводов Apple, называя их «недальновидными» и обвиняя компанию в игнорировании важных аспектов моделей мышления. Некоторые считают, что Apple преуменьшает потенциал моделей мышления из-за собственных трудностей в достижении прогресса в области искусственного интеллекта. Нельзя отрицать, что Apple Intelligence и Siri 2.0 до сих пор сталкивались с серьезными проблемами, и пока неясно, в каком направлении Apple будет двигаться дальше.

Нам придется принять выжидательную позицию, поскольку в ближайшие месяцы будет выпущено новое поколение операционных систем Apple, чтобы посмотреть, как будет развиваться ситуация.

Вы можете ознакомиться с исследованием на веб-сайте Apple здесь: https://machinelearning.apple.com/research/illusion-of-thinking

-

Маркетинг и монетизация2 недели назад

Как ML-подход удвоил первые покупки при снижении CPI, CAC, ДРР: «Яндекс Маркет» и Bidease

-

Видео и подкасты для разработчиков3 недели назад

Видео droidcon London 2025

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2026.5

-

Новости3 недели назад

Видео и подкасты о мобильной разработке 2026.6