Новости

Groq ускоряет работу языковых моделей

В Groq разработали специализированное железо — LPU (Language Processing Units).

По сравнению с человеком, языковые модели могут генерировать текст невероятно быстро. Но для некоторых, например для стартапа Groq, этого недостаточно.

Чтобы добиться еще более высокой производительности, в Groq разработали специализированное железо — LPU (Language Processing Units).

Эти LPU специально сделаны для работы с языковыми моделями и обеспечивают скорость до 500 лексем в секунду. Для сравнения, относительно быстрые LLM Gemini Pro и GPT-3.5 обрабатывают от 30 до 50 лексем в секунду, в зависимости от нагрузки, запроса, контекста и доставки.

В демонстрационном ролике, опубликованном на сайте X, основатель и генеральный директор компании Джонатон Росс в режиме реального времени ведет устный разговор с чат-ботом, находящимся на другом конце света. Хотя ChatGPT, Gemini и другие чат-боты впечатляют, Groq может сделать их молниеносными. Достаточно быстрыми, чтобы найти практическое применение в реальном мире.

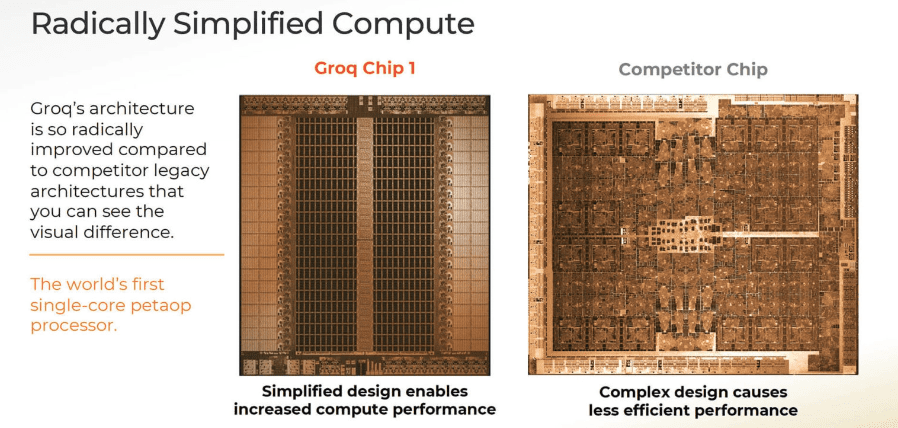

Первый GroqChip использует «тензорную потоковую архитектуру», которая, по словам Groq, разработана для обеспечения производительности, эффективности, скорости и точности.

По словам представителей стартапа, в отличие от традиционных графических процессоров, чип предлагает упрощенную архитектуру, обеспечивающую постоянную задержку и пропускную способность. Это может стать преимуществом для ИИ-приложений, работающих в реальном времени, например, в играх.

LPU также более энергоэффективны, утверждает Groq. Они позволяют снизить затраты на управление несколькими потоками и избежать неполного использования ядер, что позволяет выполнять больше вычислений на ватт.

Дизайн чипа Groq позволяет подключать несколько TSP без традиционных узких мест, связанных с кластерами GPU. По мнению Groq, это делает систему масштабируемой и упрощает требования к аппаратному обеспечению для больших ИИ-моделей .

Системы Groq поддерживают распространенные фреймворки машинного обучения, что должно облегчить интеграцию в существующие проекты. Groq продает оборудование, а также предлагает облачный API с моделями с открытым исходным кодом, такими как Mixtral. Проверить скорость работы Groq с Mixtral и Llama можно здесь.

В целом, LPU могут улучшить развертывание ИИ-приложений и стать альтернативой чипам A100 и H100 от Nvidia, которые широко используются сегодня, но являются дефицитом.

-

Маркетинг и монетизация2 недели назад

Как ML-подход удвоил первые покупки при снижении CPI, CAC, ДРР: «Яндекс Маркет» и Bidease

-

Видео и подкасты для разработчиков3 недели назад

Видео droidcon London 2025

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2026.5

-

Новости3 недели назад

Видео и подкасты о мобильной разработке 2026.6