Новости

Apple представила ReALM — новую ИИ-модель, которая может сделать Siri намного быстрее и умнее

Это означает, что если версия ReALM будет внедрена в Siri, то Siri будет лучше понимать, что пользователь имеет в виду, когда говорит ему открыть это приложение или подсказать, что означает это слово на картинке.

Apple представила новую малую языковую модель под названием ReALM (Reference Resolution As Language Modeling), которая будет работать на телефоне и сделает голосовых помощников вроде Siri умнее, помогая им понимать контекст и неоднозначные отсылки.

Это произошло в преддверии запуска iOS 18 в июне на WWDC 2024, где мы ожидаем появления новой Siri 2.0, хотя неясно, будет ли эта модель интегрирована в Siri со временем.

За последние несколько месяцев это уже не первый выход Apple на рынок искусственного интеллекта: новые модели, инструменты для повышения эффективности ИИ на небольших устройствах и партнерские отношения — все это рисует картину компании, готовой сделать ИИ центральным элементом своего бизнеса.

ReALM — это последний анонс быстро растущей команды Apple по исследованию искусственного интеллекта и первый, направленный именно на улучшение существующих моделей, чтобы сделать их быстрее, умнее и эффективнее. Компания утверждает, что в некоторых задачах она даже превосходит GPT-4 от OpenAI.

Подробности были обнародованы в новом исследовательском отчете. Сама Apple пока никак не прокомментировала результаты исследования и то, войдет ли оно в iOS 18.

Что означает ReALM для усилий Apple в области искусственного интеллекта? Похоже, что в данный момент Apple в области ИИ использует подход «выпустить все и посмотреть, что получится». Ходят слухи о партнерстве с Google, Baidu и даже OpenAI. Впрочем, компания и сама выпустила впечатляющие модели и инструменты для облегчения работы ИИ на устройствах.

Производитель iPhone работает над исследованиями в области искусственного интеллекта уже более десяти лет, но большая их часть скрыта в приложениях и сервисах. Только после выпуска последней линейки MacBook компания Apple начала использовать слово «искусственный интеллект» в своем маркетинге, и эта тенденция будет только усиливаться.

Многие исследования посвящены способам локального запуска моделей ИИ, не требующим отправки больших объемов данных для обработки в облаке. Это необходимо как для снижения стоимости работы ИИ-приложений, так и для соблюдения строгих требований Apple к конфиденциальности.

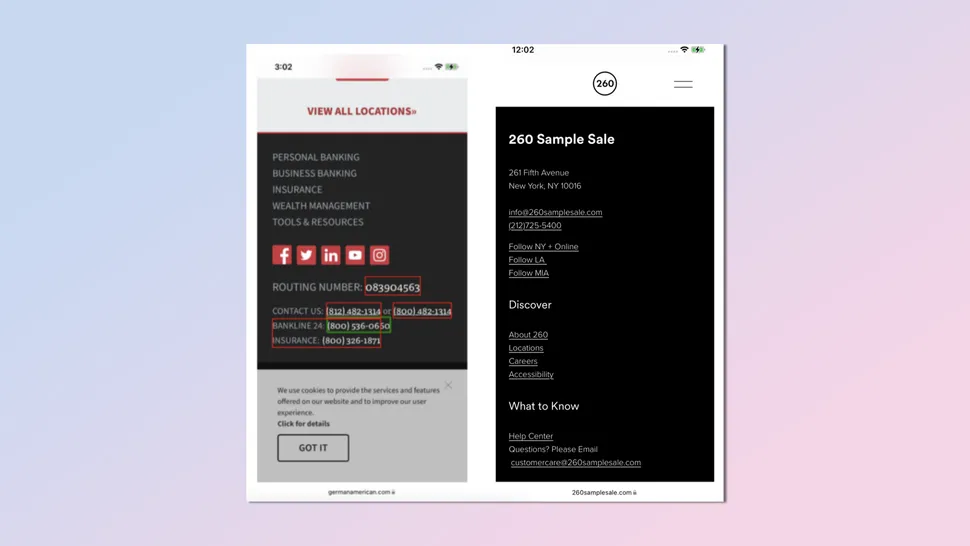

По сравнению с такими моделями, как GPT-4, ReALM совсем крошечный. Но это потому, что он не должен делать все. Его цель — обеспечить контекст для других моделей ИИ, таких как Siri. Это визуальная модель, которая реконструирует экран и помечает каждый экранный объект и его местоположение. Таким образом, создается текстовое представление визуального макета, которое может быть передано голосовому помощнику, чтобы обеспечить его контекстными подсказками для запросов пользователя.

По словам Apple, по ряду ключевых показателей точности ReALM не уступает GPT-4, несмотря на меньший размер и скорость.

«Мы особенно хотим отметить выигрыш в наборе экранных данных и обнаружили, что наша модель с подходом текстового кодирования способна работать почти так же хорошо, как GPT-4, несмотря на то, что последней предоставляются скриншоты», — пишут авторы.

Это означает, что если версия ReALM будет внедрена в Siri, то Siri будет лучше понимать, что пользователь имеет в виду, когда говорит ему открыть это приложение или подсказать, что означает это слово на картинке.

Это также даст Siri больше разговорных возможностей без необходимости развертывания большой языковой модели в масштабах Gemini. В сочетании с другими недавними исследованиями Apple, позволяющими получать ответы от одной подсказки, это признак того, что Apple продолжает активно инвестировать в ИИ-ассистентов, а не просто полагается на сторонние модели.

-

Видео и подкасты для разработчиков3 недели назад

Разработка видеоредактора

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2025.50

-

Вовлечение пользователей3 недели назад

Инженерия уверенности: почему ваш онбординг, вероятно, слишком короткий

-

Видео и подкасты для разработчиков2 недели назад

От идеи к CVE: как находить уязвимости в Android