A/B тестирование

Почему результаты большинства A/B тестов — полная чепуха

Джастин Мегахэн из Mixpanel утверждает, что проведение А/Б тестов в большинстве случаев то же самое, что просто бросать монетку и смотреть что выпадет.

Джастин Мегахэн из Mixpanel утверждает, что проведение A/B тестов в большинстве случаев то же самое, что просто бросать монетку и смотреть, что выпадет.

Сегодня каждый, кто работает с продуктом или занимается маркетингом, знает, что такое A/B тестирование. Что мы не знаем или по крайней мере не признаем, это то, что большинство A/B тестов не приносят никакого результата.

Компания AppSumo выяснила, что только 1 из 8 тестов приносит результат. В Kaiser Fung подсчитали, что от 80 до 90 A/B тестов, который они провели, принесли статистически незначимые результаты.

Тем не менее, много новых тестировщиков берутся за A/B тестирование, думая, что они быстро и легко получат результаты. Проведя несколько простых тестов, они ожидают, что найдя правильный цвет для кнопки или чуть-чуть изменив вон то поле, конверсии – бах – и подскочат на 38% магическим образом.

Они начинают проводить тестирование на своих приложениях или сайтах, и тут внезапно вмешивается суровая реальность. Тесты не приводят к определённым результатам. Они приносят «статистически незначимые» результаты, и никаких ценных выводов о продукте или пользователях. Что происходит? Где же подъем на 38% и последующие овации?

Не расстраивайтесь. Если вы собираетесь проводить A/B тестирование, у вас могут получиться абсолютно бессмысленные результаты. Но если вы как следует подумаете, прежде чем его делать, то вы сможете улучшить свой продукт.

Вам кажется, что вы сможете что-то извлечь из любого A/B теста, который проведете. Никто (почти) не пишет посты в блогах о том, как они протестировали 3 варианта и не увидели значительной разницы в конверсии. Это означает то, что результаты настолько незначимы статистически, что не приводят ни к каким выводам из эксперимента. По сущности, это всё равно, что проводить эксперимент вообще не сделав никакой разницы между А и Б.

Представьте, вы подкидываете две монеты, по 20 раз каждую. На монете А орел выпадает 12 раз. На монете B – 9 раз. Вы же не станете утверждать, что вы вычислили монету, на которой на 33% вероятнее выпадет орел, правда? Вы знаете, что это просто дело случая. А не статистически значимо.

Затем, если вы бросите каждую монетку еще 180 раз, и на монете А орел выпадет 120 раз, а на B – 90 раз, может показаться, что получится что-то осмысленное. Но, опять же, мы знаем, что это не так. После 200 бросков может быть разница в этих числах, но это случайность. А разница – просто помехи.

Это может показаться глупым экспериментом. Конечно, две одинаковые монеты не будут вести себя по-разному. Но, честно, именно поэтому так много A/B тестов не имеют смысла. Мы тратим время тестируя варианты, между которыми нет значимой разницы. И неудивительно, что это ни к чему не приводит.

Если кого и нужно винить, то этот глупый вариант кнопки.

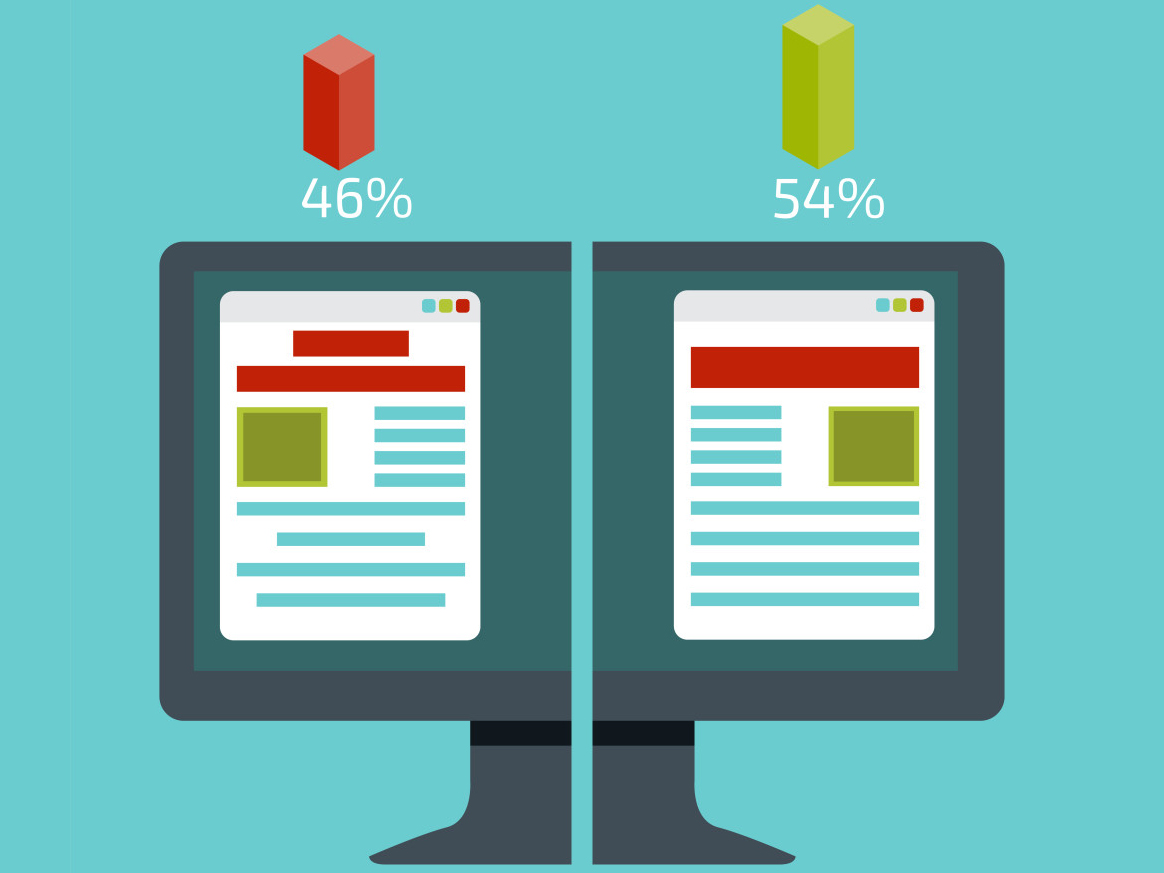

Эксперименты с цветом кнопки — это азы A/B тестирования. И до сих пор кто-нибудь, объясняя принцип таких тестов, использует этот пример, где в одном варианте страницы кнопка покупки была зеленая, а в другом красная. Проведете тест — узнаете, какой цвет кнопки обладает большим процентом конверсии.

Правда в том, что некоторые компании провели такой эксперимент и реально получили осмысленные результаты для улучшения своего продукта. Если вы хотите, чтобы пользователь с чем-то взаимодействовал, то это определенно стоит выделить на фоне других объектов. И всё-таки, хотя изменение цвета кнопки – это отличный способ описания A/B тестирования, ваш продукт это вряд ли улучшит.

Я провел свой собственный бессмысленный тест около 1,5 месяца назад.

Я слышал, что если начать письмо с названия компании, то это может улучшить уровень просмотра. У нас была публикация на тему превращения QuizUp в социальную платформу. Мы разослали одной половине наших пользователей материал под названием «Why 15 million users weren’t good enough for this mobile trivia app», а другой «Mixpanel — Why 15 million users weren’t good enough for this mobile trivia app». Очень простой тест, правда? Если название компании влияет, то мы могли бы использовать это для улучшения количества просмотров рассылки.

Итак, письмо ушло сотням тысяч наших пользователей в двух вариантах. И я с нетерпением ждал успеха.

Когда же результаты появились, они не могли быть еще менее статистически незначимыми. Письмо с заголовком без «Mixpanel» набрало 22.75% просмотров. Письмо с указанием названия компании – 22.73%. Разница — 0.02%.

В сотнях тысяч моих отправленных писем разница составляла 20 открытий. Во всех отношениях и с любой точки зрения, я просто бросал монетки.

Даже в таком масштабном образце, особой разницы результатов не было, чтобы это хоть к чему-то привело. Я ничего не узнал, кроме того, что к тестам нужно относиться внимательнее.

Так что я должен был сделать, чтобы получить значимые результаты?

Что ж, во-первых, мне нужно было написать совершенно другую тему письма. Например, менее интригующую, но более понятную «Why QuizUp turned the fastest-growing game in history into a social platform». Этот контраст с наибольшей вероятностью бы принес статистически значимые результаты.

Но даже тогда, что бы я узнал из этого помимо того, что у одного варианта дела шли лучше, чем у другого? Какие действия бы я смог предпринять на основе этого? Возможно, если бы я провел еще несколько тестов, я бы пришел к заключению, предпочитают ли наши пользователи интригующие заголовки или более конкретные.

Мой тест был бессмысленным, потому что он был плохо продуман и не был частью большей стратегии, отвечающей на вопрос о том, что имеет значение для наших пользователей. Он был быстрым и простым, но ни к чему не привел. A/B тестирование – не такое легкое, как кажется. Если вам нужны результаты, то придется потрудиться.

Или же уделить много времени тестированию мелочей, например, разных картинок, немного отличающихся вариантов дизайна и другого для незначительных улучшений. Это одна команда A/B тестеров, обещающих вам «оптимизировать свой путь к успеху». Другая команда включает тех, кто тестирует глобально разные вещи, например, два разных вида введения для пользователя.

Вы можете извлечь ценные уроки и улучшить свой продукт благодаря A/B тестированию, но придется потрудиться.

Я не один так думаю. Недавно, я разговаривал с Хари Анант, сооснователем Jobr насчет не очень значимых A/B тестов, которые они провели для улучшения приобретения пользователей.

Мы хотели улучшить наше введение, чтобы привлечь больше пользователей в приложение.

Jobr – приложение, которое позволяет соискателям работы свайпить так же, как в Tinder.

«Мы определили два ключевых момента в нашей воронке и создали большой список вариантов для каждого эксперимента, чтобы обеспечить правильный охват. После того, как мы проверили каждый из вариантов, мы смогли оптимизировать процесс и увеличить конверсию на 225%».

Jobr существенно поменяли свой процесс онбоардинга основываясь на том, на каком этапе пользователи «слились».

A/B тесты Cozi были более близки к варианту «оптимизируйте свой путь к успеху». Команда тестировала незначительные эстетические изменения, например, переход на более светлый фон, уменьшение количества шагов введения и другие мелочи. Ни одно изменение не привело к значительному улучшению конверсий. Но в совокупности они помогли улучшить завершение пользователем введения с 55% до 76%.

Проводите тесты, которые дадут значимые результаты

Полезные результаты таких экспериментов не были случайны. Если тестировать значимые аспекты продукта, которые могут иметь серьезное воздействие на пользовательское поведение, то можно получить полезные выводы. И, конечно, такие эксперименты должны быть проведены несколько раз, чтобы дать статистически значимые результаты.

Так что если вам надоели бредовые результаты и вы хотите улучшить конверсии на 38%, тогда выложитесь на полную.

-

Маркетинг и монетизация2 недели назад

Как ML-подход удвоил первые покупки при снижении CPI, CAC, ДРР: «Яндекс Маркет» и Bidease

-

Видео и подкасты для разработчиков3 недели назад

Видео droidcon London 2025

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2026.5

-

Новости3 недели назад

Видео и подкасты о мобильной разработке 2026.6