Новости

Animate Anyone приближает создание видео-дипфейков

Это огромный скачок по сравнению с предыдущим уровнем техники, который давал гораздо больше артефактов или полностью терял важные детали.

Если дипфейки неподвижных изображений уже достаточно хороши, то скоро нам придется столкнуться с генерируемыми видеороликами. С помощью Animate Anyone вы сможете сделать видео с любым человеком, чья фотография у вас есть.

Новая технология генеративного видео была разработана исследователями из Института интеллектуальных вычислений Alibaba Group. Это большой шаг вперед по сравнению с предыдущими системами преобразования изображений в видео, такими как DisCo и DreamPose, которые вышли только летом, но теперь уже стали историей.

То, что может Animate Anyone, отнюдь не является беспрецедентным, но оно прошло тот сложный промежуток между «нелепым академическим экспериментом» и «достаточно хорошо, если не присматриваться». Как мы все знаем, следующая стадия — это просто «достаточно хорошо», когда люди даже не удосуживаются присмотреться, потому что предполагают, что это реальность. Именно на этом этапе находятся изображения и текстовые разговоры с ИИ, разрушающие наше чувство реальности.

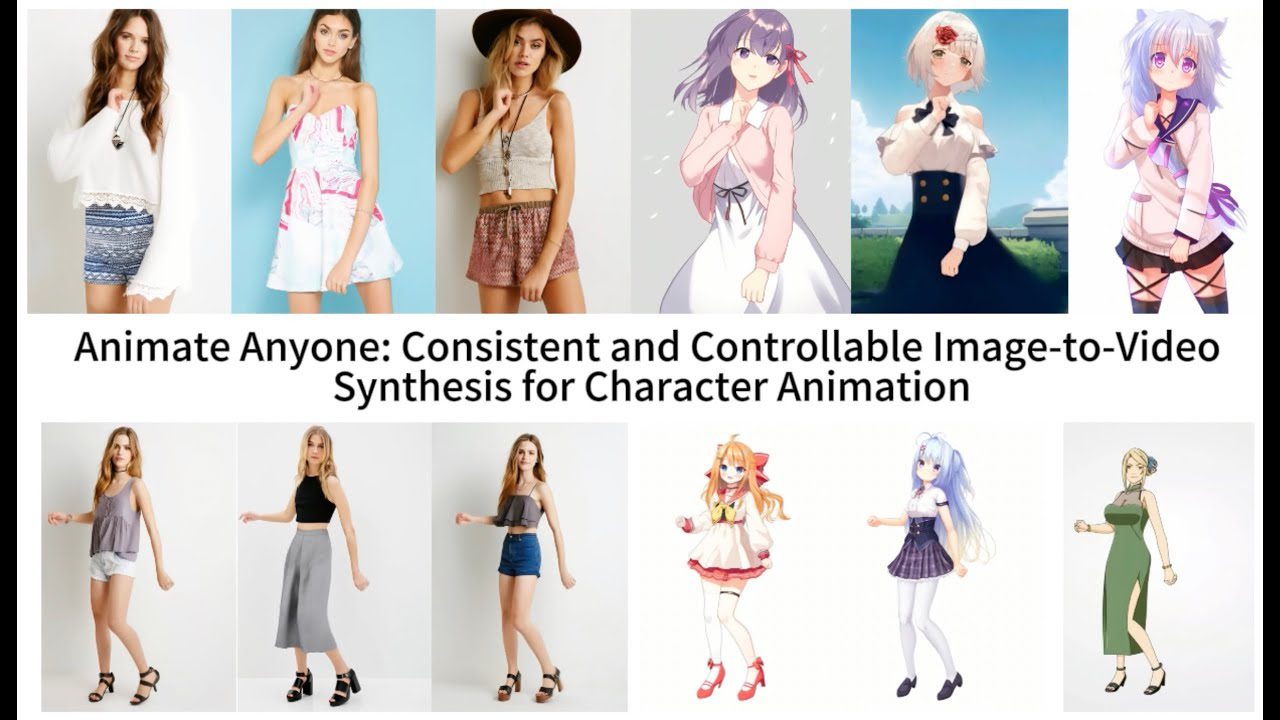

Модели преобразования изображений в видео, подобные этой, начинают с извлечения деталей, таких как черты лица и поза, из эталонного изображения, например модной фотографии модели в платье, выставленном на продажу. Затем создается серия изображений, на которых эти детали отображаются в очень незначительно отличающихся позах, которые могут быть переведены в движение или сами извлечены из другого видео.

Предыдущие модели показали, что это возможно сделать, но было много проблем. Галлюцинации были большой проблемой, так как модель должна придумывать правдоподобные детали, например, как рукав или волосы могут двигаться, когда человек поворачивается. Это приводит к появлению множества очень странных образов, что делает получившееся видео далеко не убедительным. Но Animate Anyone стала намного лучше, хотя все еще далека от совершенства.

Технические особенности новой модели недоступны большинству, но в статье подчеркивается новый промежуточный шаг, который «позволяет модели всесторонне изучить отношения с эталонным изображением в последовательном пространстве признаков, что значительно способствует улучшению сохранения деталей внешности». Благодаря улучшению сохранения основных и мелких деталей, генерируемые изображения в дальнейшем будут иметь более прочную опорную информацию для работы и получаться намного лучше.

Разработчики демонстрируют свои результаты в нескольких контекстах. Модели одежды принимают произвольные позы, не деформируясь, и одежда не теряет свой рисунок. 2D-фигурка из аниме оживает и убедительно танцует. Лионель Месси делает несколько характерных движений.

Получающиеся видео по прежнему далеки от совершенства — особенно это касается глаз и рук, которые представляют особую проблему для генеративных моделей. А позы, которые лучше всего передаются, наиболее близки к оригиналу; например, если человек поворачивается, модель с трудом поспевает за ним. Но это огромный скачок по сравнению с предыдущим уровнем техники, который давал гораздо больше артефактов или полностью терял важные детали, такие как цвет волос или одежды человека.

На данный момент технология слишком сложна и ошибочна для широкого использования, но в мире ИИ так долго не бывает. По крайней мере, команда пока не выкладывает код в открытый доступ. Хотя у них есть страница на GitHub, разработчики пишут: «Мы активно работаем над подготовкой демо-версии и кода к публичному релизу. Хотя мы не можем назвать конкретную дату релиза в данный момент, пожалуйста, будьте уверены, что намерение предоставить доступ как к демо-версии, так и к нашему исходному коду твердое».

-

Новости4 недели назад

Видео и подкасты о мобильной разработке 2026.4

-

Видео и подкасты для разработчиков4 недели назад

Изоляционно-плагинная архитектура в Dart-приложениях, переносимость на Flutter

-

Видео и подкасты для разработчиков3 недели назад

Видео droidcon London 2025

-

Новости3 недели назад

Видео и подкасты о мобильной разработке 2026.5